Die inhärente Zufälligkeit der KI-Textgenerierung macht das Problem noch komplexer. Selbst wenn ein Sprachmodell denselben Prompt mehrfach erhält, kann es jedes Mal leicht unterschiedliche Erklärungen zu seinen eigenen Fähigkeiten oder Einschränkungen liefern – und damit Variabilität erzeugen, wo Nutzer eigentlich Konsistenz erwarten.

Mehrere unsichtbare Schichten beeinflussen, was KI-Systeme sagen

Selbst wenn ein Sprachmodell theoretisch ein perfektes Verständnis seiner internen Funktionsweise hätte, enthalten moderne KI-Assistenten zusätzliche Schichten, die für das Modell vollständig unsichtbar bleiben. Heutige KI-Systeme bestehen nicht aus einem einzigen Modell, das isoliert antwortet – sie sind komplexe, orchestrierte Systeme aus mehreren Modellen und Komponenten, die unterschiedliche Aufgaben übernehmen und oft ohne gegenseitige Kenntnis arbeiten.

OpenAI nutzt zum Beispiel eine eigene Moderationsebene, deren Funktionsweise völlig unabhängig vom Sprachmodell ist, das die Antworten erzeugt. Wenn also ein Nutzer ChatGPT fragt, was es kann oder nicht kann, hat das antwortende Modell keinerlei Bewusstsein darüber, welche Moderationsfilter eingreifen könnten, welche Tools im Hintergrund aktiviert werden oder wie die Assistenzpipeline seine Ausgabe verändert oder verwirft.

Das ist vergleichbar damit, ein Team in einem großen Unternehmen zu fragen, welche Regeln, Beschränkungen oder Fähigkeiten ein anderes Team hat, das unter völlig unterschiedlichen Strukturen arbeitet.

Noch entscheidender ist, dass die Formulierung des Nutzers immer das Ergebnis des Modells beeinflusst. Wenn jemand eine Frage mit Angst oder Sorge stellt – etwa ob eine KI „alles zerstört“ habe, nachdem ein Datenbankfehler auftritt – spiegelt das Sprachmodell oft diese emotionale Färbung wider. Statt eine präzise technische Einschätzung zu liefern, erzeugt es womöglich eine Antwort, die den emotionalen Tonfall des Prompts verstärkt und so die Angst des Nutzers ungewollt bestätigt.

Dies schafft eine Rückkopplungsschleife: Gestresste Nutzer erhalten Antworten, die ihre Befürchtungen scheinbar bestätigen – nicht, weil das System die Situation richtig analysiert hätte, sondern weil es Text generiert, der zur emotionalen Prägung der Frage passt.

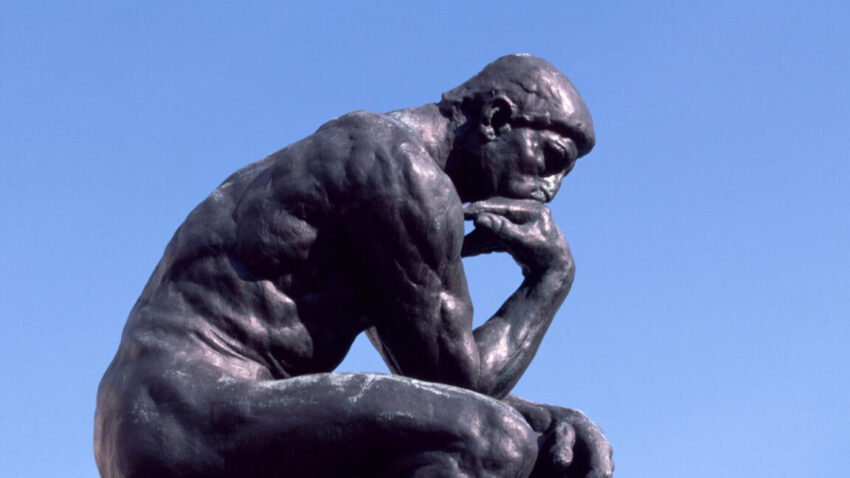

Menschen neigen dazu anzunehmen, dass ein System, das seine „Gedanken“ erklärt, über eine Form von Selbstbewusstsein verfügt. Doch große Sprachmodelle sagen nicht die Wahrheit über interne Zustände – sie erzeugen lediglich wahrscheinliche Textmuster. Ihre Erklärungen über ihren eigenen „Denkprozess“ sind keine echten Einsichten, sondern sprachliche Simulationen, die auf Trainingsdaten basieren. Diese Ausgaben als echte Selbstreflexion zu behandeln, ist ein Kategorienfehler.